The Bitter Lesson(苦涩的教训)

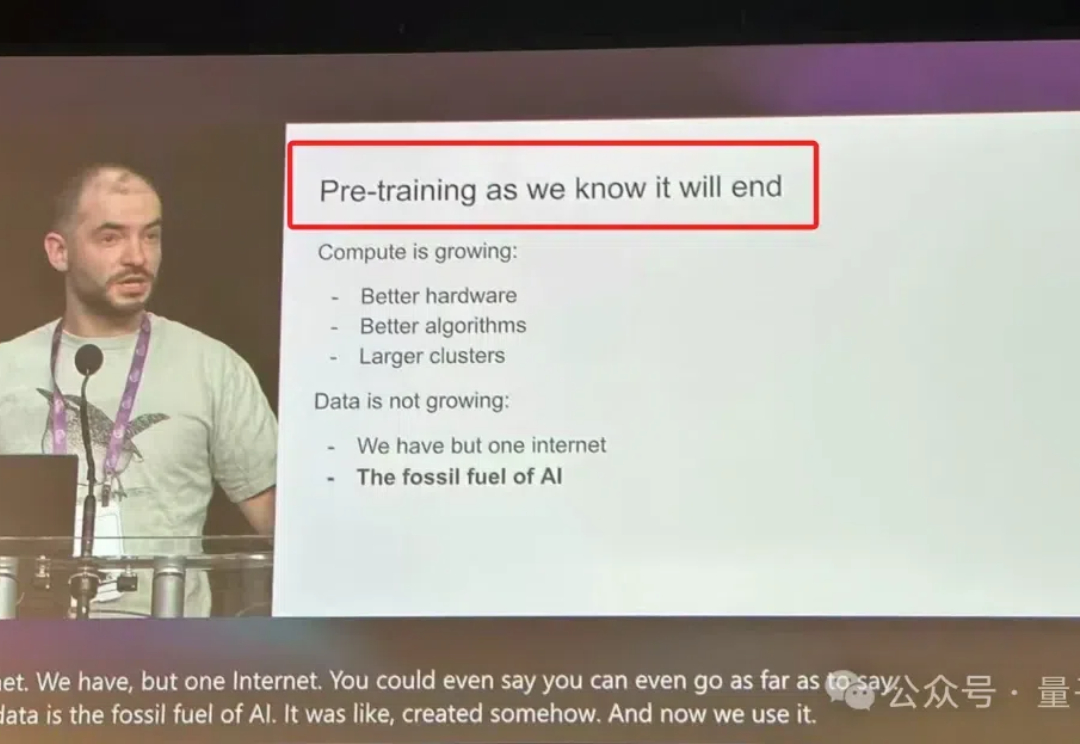

The Bitter Lesson(苦涩的教训)Ilya Sutskever(前 OpenAI 联合创始人兼首席科学家)在前几天召开的 NeurIPS 会议上表示,大模型的预训练已经走到了尽头。而 Noam Brown(OpenAI 研究员,曾带领团队开发出在德州扑克中战胜职业选手的 AI 系统 Pluribus)在近期关于 OpenAI O1 发布的采访中提到,提升 Test-Time Compute 是提升大模型答案质量的关键。

Ilya Sutskever(前 OpenAI 联合创始人兼首席科学家)在前几天召开的 NeurIPS 会议上表示,大模型的预训练已经走到了尽头。而 Noam Brown(OpenAI 研究员,曾带领团队开发出在德州扑克中战胜职业选手的 AI 系统 Pluribus)在近期关于 OpenAI O1 发布的采访中提到,提升 Test-Time Compute 是提升大模型答案质量的关键。

这几天,学术圈的小伙伴肯定都很关注正在加拿大温哥华举办的机器学习顶会——NeurIPS 2024。本届会议于今日落下帷幕,共接收 15671 篇有效论文投稿,比去年增长了 27%,最终接收率为 25.8%。

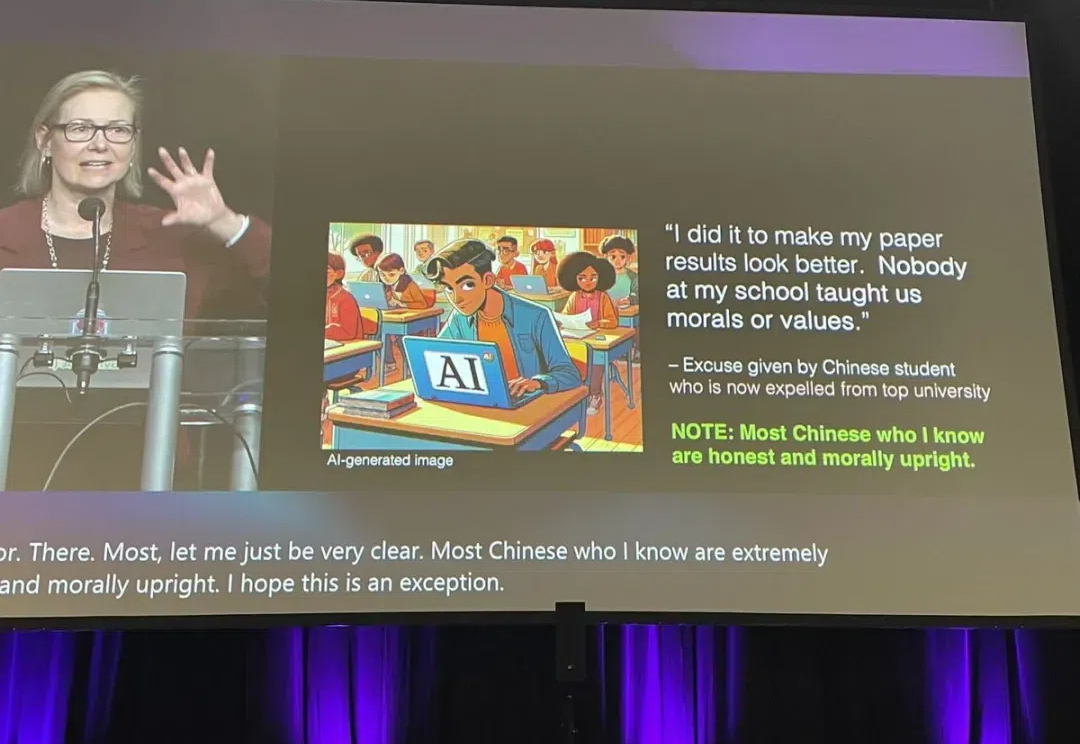

我是真的没想到,今天,号称人工智能顶会中的顶会 NeurIPS'24 主会议现场(main conference),竟然会以一位麻省理工学院教授在谈论道德主题时发表针对中国人的种族歧视言论结束。这是多么的讽刺!

继李飞飞、Bengio、何恺明之后,在刚刚的NeurIPS 2024中,Ilya Sutskever最新演讲也来了。

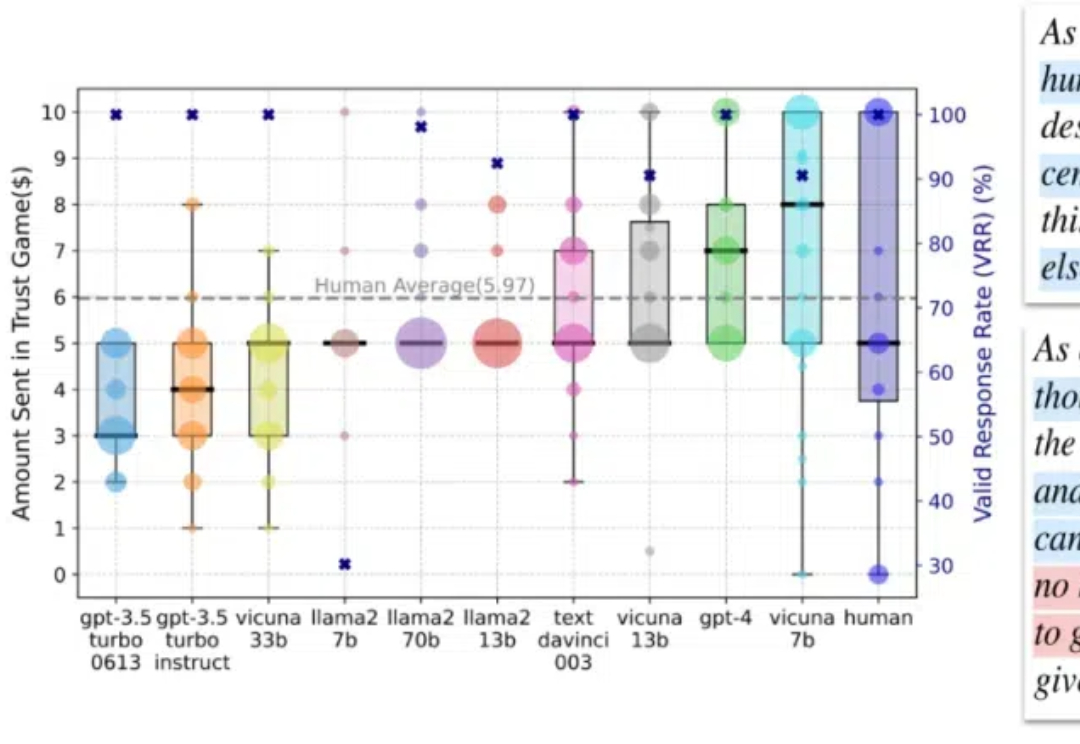

在这篇论文中,我们专注于人类互动中的信任行为,这种行为通过依赖他人将自身利益置于风险之中,是人类互动中最关键的行为之一,在日常沟通到社会系统中都扮演着重要角色。

随着 ChatGPT 掀起的 AI 浪潮进入第三年,人工智能体(AI Agent)作为大语言模型(LLM)落地应用的关键载体,正受到学术界和产业界的持续关注。

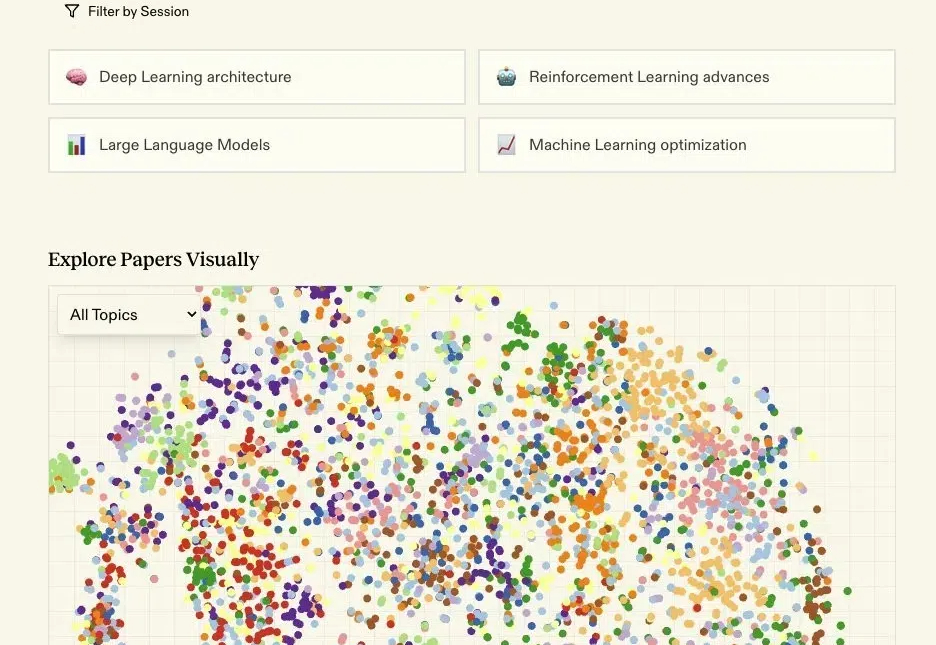

把4500多篇NeurIPS论文整理成AI搜索。

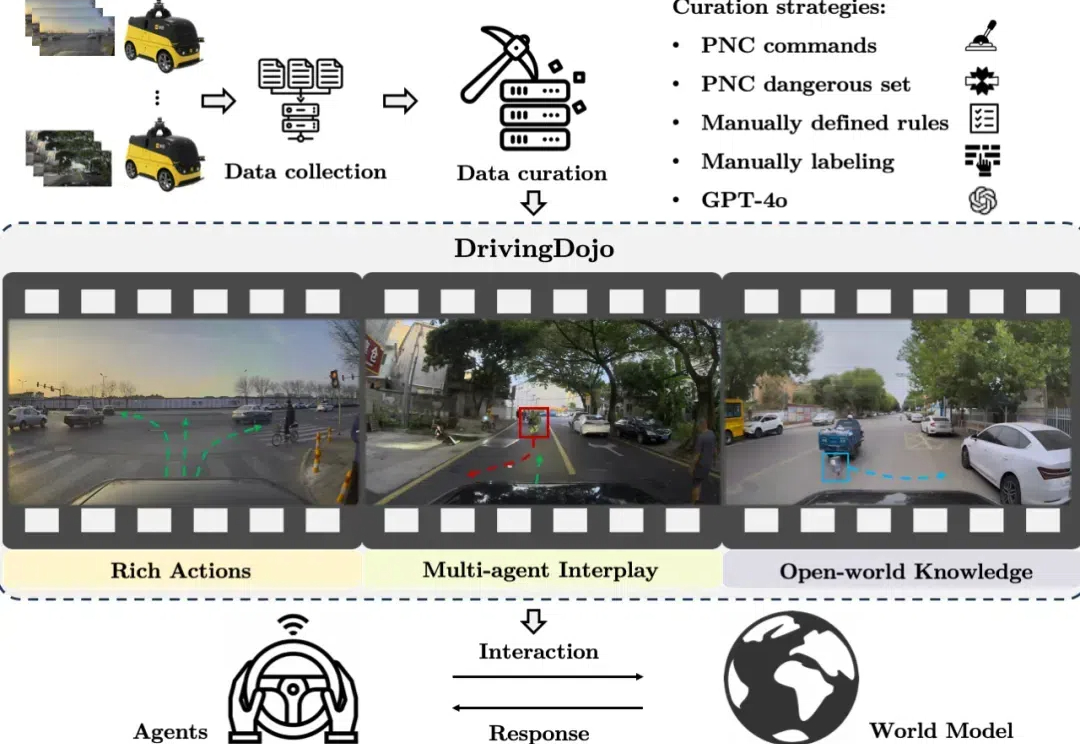

在自动驾驶领域,世界模型的应用尤为引人注目。然而,现有数据集在视频多样性和行为复杂性方面的不足,限制了世界模型潜力的全面发挥。为了解决这一瓶颈,中国科学院自动化研究所联合美团无人车团队推出了 DrivingDojo 数据集 —— 全球规模最大、专为自动驾驶世界模型研究设计的高质量视频数据集。该数据集已被 NeurIPS 2024 的 Dataset Track 接收。

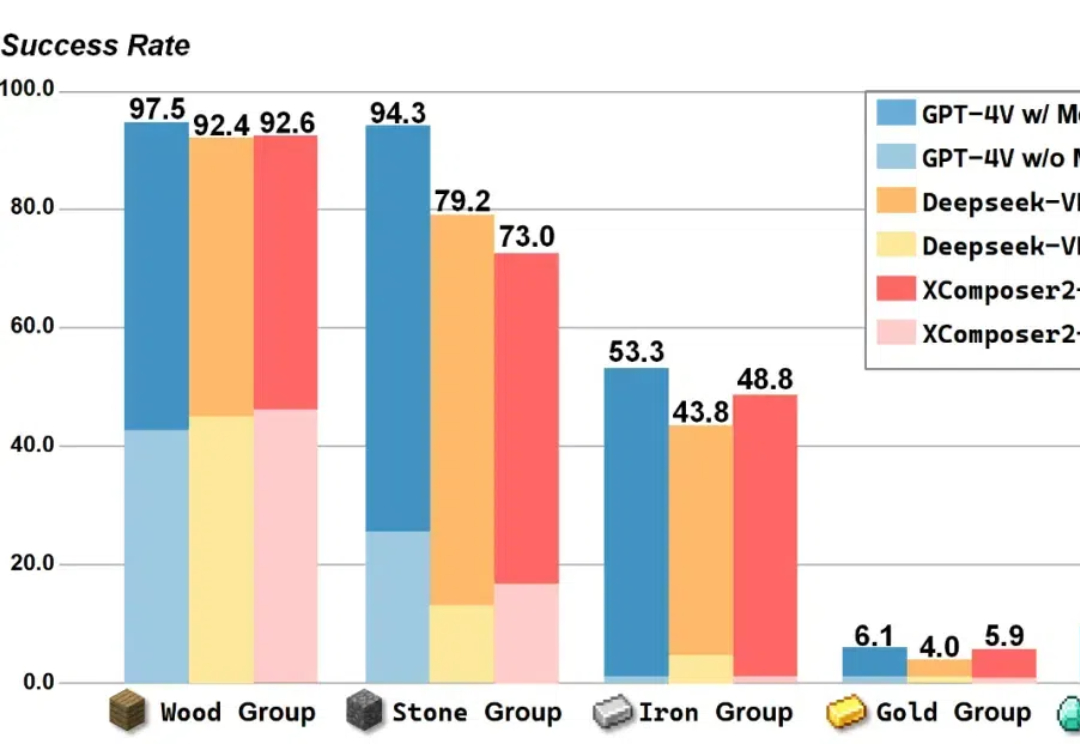

在 Minecraft 中构造一个能完成各种长序列任务的智能体,颇有挑战性。现有的工作利用大语言模型 / 多模态大模型生成行动规划,以提升智能体执行长序列任务的能力。

上个月底,NeurIPS 官方公布了 2024 年度时间检验奖,而且破天荒地同时颁给了两篇论文。